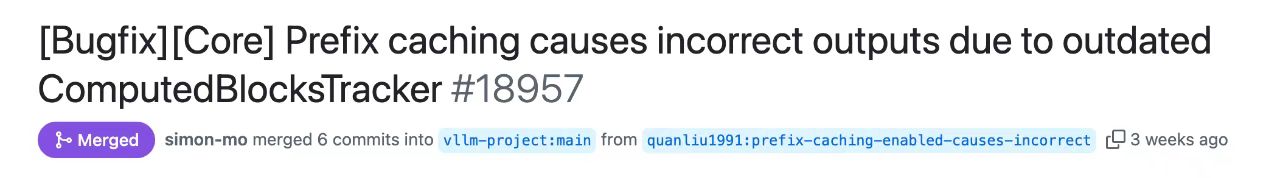

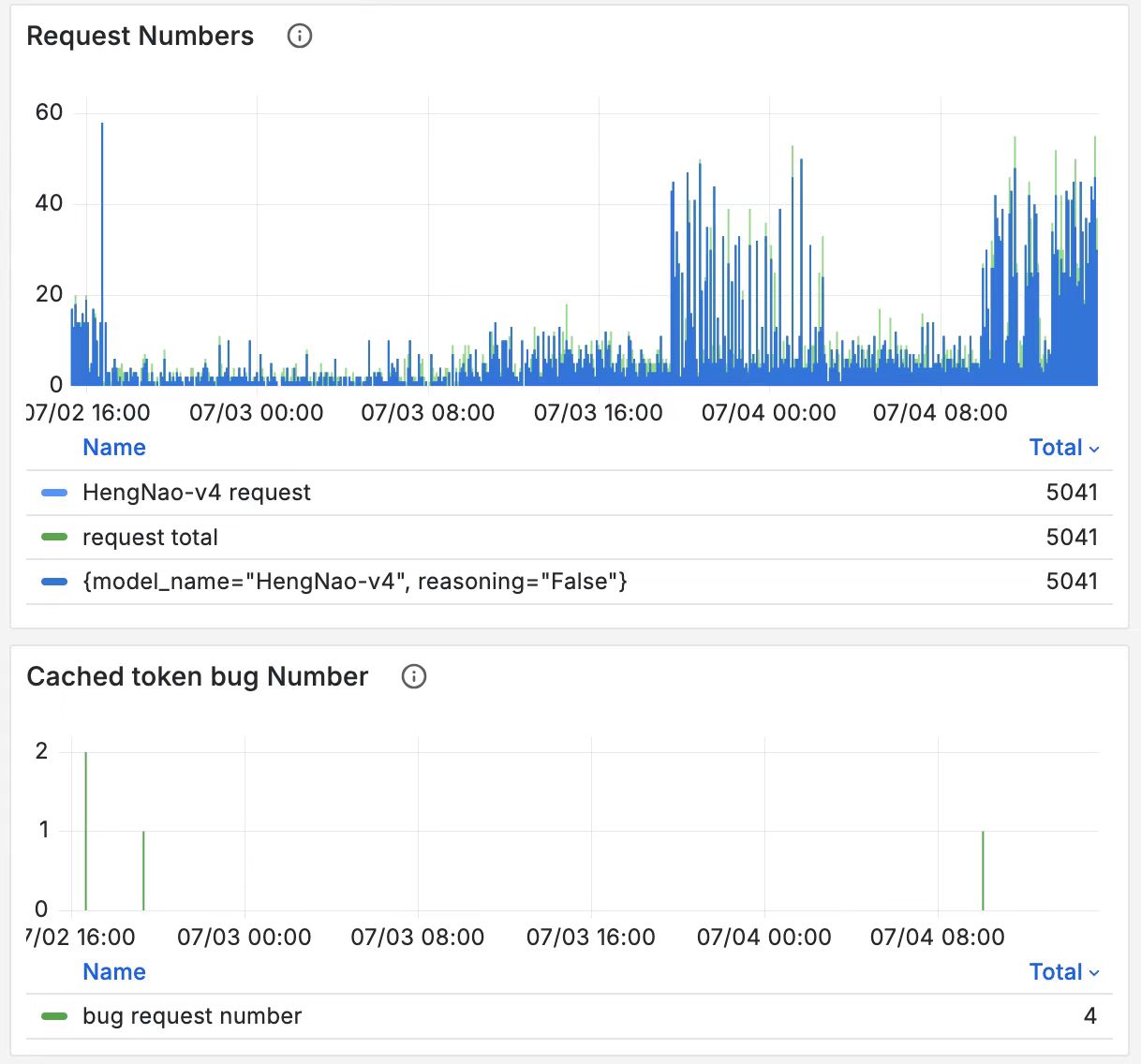

当 AI 技术加速融入千行百业,每一次模型迭代、每一处代码优化,都关乎产业落地的效率与质量。在 AI 开源生态中,恒脑团队始终以 “社区共建者” 的身份,用专业能力解决行业痛点,用开放态度反哺生态发展 ——恒脑新版本上线前的一场 “bug 攻坚战”,正是我们技术实力与社区责任感的生动缩影。于细节处见担当:主动按下“暂停键”,把问题挡在落地前在恒脑新版本模型即将正式上线的关键节点,恒脑团队以极致严谨的态度开展上线前最后一轮压力测试。当监测数据显示:在高并发场景下的 156 条请求中,竟有 40% 出现重复响应问题时,我们第一时间果断停止上线流程。“宁可推迟发布,也绝不把隐患留给用户。”—— 这是恒脑团队的技术底线。我们当即成立专项攻坚小组,将 “解决重复请求问题” 列为核心目标,从模型推理链路的每一个环节入手,开启了一场与 “隐藏 bug” 的较量。一周攻坚破局:抽丝剥茧,锁定 vLLM 核心代码 “症结”定位问题的过程,远比想象中更具挑战。AI 推理链路涉及算子运算、采样策略、缓存机制等多个复杂模块,任何一个环节的细微偏差,都可能引发连锁反应。专项小组成员放弃休息时间,围绕 “重复请求” 这一现象,提出了数十种假设:是算子精度不足导致结果偏差?是采样逻辑漏洞引发重复输出?还是缓存更新不及时造成数据冗余?为验证每一种假设,团队设计了多组对比实验:搭建独立测试环境,模拟高并发场景;逐行跟踪代码执行流程,记录关键节点数据;与行业内技术专家交流,借鉴同类问题的排查经验。经过整整一周的“连轴转”—— 从数百次实验验证,到数十轮代码复盘,再到一次次推翻重来 —— 团队终于排除了所有干扰项,锁定了问题的核心:vLLM(当前主流的大模型推理框架)最核心的代码中,存在一处数据不一致的漏洞。正是这一隐藏的漏洞,导致模型在高并发推理时,出现结果错误、重复输出、逻辑断裂等问题。这一发现,不仅为解决当前问题提供了关键方向,更填补了 vLLM 框架在特定场景下的技术空白。找到“症结” 后,恒脑团队并未止步于 “解决自身问题”,而是以 “开源生态共建者” 的视角,推动问题的彻底解决与经验共享。团队首先基于问题根源,制定了针对性的修复方案:重构 vLLM 核心代码中的数据同步逻辑,补充数据一致性校验机制,并通过多轮压力测试验证修复效果 —— 在相同的高并发场景下,重复请求率从 40% 降至 0,推理结果的准确性与稳定性均达到预期标准。更重要的是,我们深知:开源生态的价值,在于“一人解决问题,万人受益”。修复完成后,恒脑团队主动将优化后的代码提交至 vLLM 开源社区,并与社区核心维护团队展开深度沟通:详细说明问题出现的场景、排查过程、修复思路,以及多组测试数据;根据社区反馈,进一步优化代码的兼容性与可扩展性,确保修复方案能适配更多开发者的使用需求。

最终,我们的修复代码成功合入 vLLM 0.9.2rc 版本,成为该版本的重要功能优化之一。与此同时,团队还对该 bug 的潜在影响面进行了全面监测与评估,形成了详细的技术报告,为社区开发者提供了 “如何规避类似问题” 的参考依据,帮助更多人少走弯路。

此次恒脑新版本上线前的 “bug 攻坚与开源贡献”,并非偶然,而是恒脑团队多年技术积累与社区理念的必然结果。在 AI 领域,恒脑团队深耕大模型训练、推理优化、工程化落地等核心环节,拥有一支由资深算法工程师、系统架构师组成的技术团队,曾主导或参与多个国家级 AI 项目,在高并发推理优化、模型压缩、低延迟部署等方向积累了丰富的实战经验。我们始终认为:技术的价值不仅在于 “解决自己的问题”,更在于 “通过技术分享,推动整个行业进步”。未来,恒脑团队将继续以更积极的态度参与 AI 开源社区建设:一方面,持续深耕技术,在大模型推理框架优化、行业场景解决方案等领域输出更多优质成果;另一方面,主动分享技术经验,无论是发现的 bug、优化的代码,还是实战中的方法论,都将通过开源社区、技术博客、行业论坛等渠道与大家共享。

因为我们坚信:AI 生态的繁荣,需要每一位参与者的投入;而恒脑,愿以技术为笔,以诚意为墨,与所有合作伙伴、社区开发者携手,共绘 AI 产业的美好未来。

立即体验恒脑3.0

立即体验恒脑3.0

智能化安全服务

智能化安全服务 安全托管服务

安全托管服务 侦测服务

侦测服务 保护检测服务

保护检测服务 监控分析服务

监控分析服务 应急服务

应急服务 运营管理服务

运营管理服务